티스토리 뷰

서론: AI 시대, HBM과 DRAM의 중요성

우리는 지금 인공지능(AI) 혁명의 한가운데에 서 있습니다. 챗GPT와 같은 대규모 언어 모델(LLM)부터 자율주행, 복잡한 과학 시뮬레이션에 이르기까지, 과거에는 상상하기 어려웠던 연산들이 일상화되고 있습니다. 이러한 혁신은 단순히 중앙처리장치(CPU)나 그래픽처리장치(GPU)의 발전만으로 이루어진 것이 아닙니다. 방대한 데이터를 빠르고 효율적으로 처리하기 위한 ‘메모리’ 기술의 진화 없이는 불가능했을 것입니다. 특히 최근 몇 년간 고대역폭 메모리(HBM)라는 이름이 AI 반도체와 고성능 컴퓨팅(HPC) 분야에서 뜨거운 감자로 떠오르고 있습니다.

메모리 기술은 컴퓨터 시스템의 성능을 좌우하는 핵심 요소입니다. 아무리 강력한 프로세서가 있더라도, 필요한 데이터를 제때 공급받지 못한다면 제 성능을 발휘할 수 없습니다. 전통적으로 시스템의 주력 메모리로 사용되어 온 DRAM(Dynamic Random Access Memory)은 그동안 눈부신 발전을 거듭하며 컴퓨팅 환경의 근간을 이루어 왔습니다. 하지만 AI 시대가 요구하는 폭증하는 데이터 처리량과 연산 속도는 기존 DRAM만으로는 감당하기 어려운 수준에 도달했습니다. 여기서 HBM DRAM 차이에 대한 명확한 이해가 중요해집니다.

AI 학습과 추론, 빅데이터 분석, 과학 연산 등 고성능 컴퓨팅 환경에서는 초당 수 테라바이트(TB)에 달하는 막대한 데이터를 프로세서와 메모리 간에 끊임없이 주고받아야 합니다. 이러한 요구사항을 충족시키기 위해 고성능 컴퓨팅 메모리의 새로운 표준으로 등장한 것이 바로 HBM입니다. HBM은 기존 DRAM의 한계를 극복하기 위해 설계된 혁신적인 기술로, AI 반도체 메모리 시장에서 그 중요성이 날마다 커지고 있습니다. 하지만 HBM이 모든 환경에서 DRAM을 대체하는 만능 해결책은 아닙니다. 각각의 기술은 고유한 특성과 장단점을 가지고 있으며, 특정 애플리케이션에 최적화된 활용처가 존재합니다.

따라서 AI 시대의 기술 동향을 이해하고, 최적의 컴퓨팅 환경을 구축하기 위해서는 HBM이란 무엇이며, 전통적인 DRAM 원리와는 어떤 핵심적인 HBM DRAM 차이를 가지는지 명확하게 알아야 합니다. 이 글에서는 비전공자도 쉽게 이해할 수 있도록 기본적인 개념부터 시작하여, 전문가들이 흥미를 느낄 만한 심층적인 기술적 내용까지, HBM과 DRAM의 모든 것을 완벽하게 해부해보고자 합니다. 오늘날의 컴퓨팅 시스템을 지탱하는 두 기둥, HBM과 DRAM의 세계로 함께 떠나봅시다.

DRAM이란 무엇이며, 어떻게 작동하는가?

우리가 일상에서 사용하는 PC, 스마트폰, 그리고 데이터 센터의 거대한 서버까지, 대부분의 디지털 기기는 DRAM이라는 메모리 기술에 의존하고 있습니다. DRAM은 Dynamic Random Access Memory의 약자로, 전원이 공급되는 동안 데이터를 일시적으로 저장하는 휘발성(Volatile) 메모리입니다. 이름에서 알 수 있듯이 ‘다이내믹(Dynamic)’이라는 단어가 붙은 이유는 저장된 데이터를 유지하기 위해 지속적인 ‘재충전(Refresh)’이 필요하기 때문입니다.

DRAM의 기본 원리 및 구조

DRAM 원리를 이해하기 위해서는 DRAM 칩 내부의 기본적인 구성 요소를 살펴봐야 합니다. DRAM은 수십억 개의 작은 메모리 셀(Memory Cell)로 이루어져 있습니다. 각 메모리 셀은 단 하나의 트랜지스터(Transistor)와 하나의 커패시터(Capacitor)로 구성됩니다. 이 커패시터가 바로 데이터(1 또는 0)를 전하 형태로 저장하는 역할을 합니다.

- 커패시터 (Capacitor): 전기를 일시적으로 저장하는 부품입니다. 전하가 충전되면 '1', 방전되면 '0'으로 인식하여 데이터를 표현합니다. 마치 물을 담아두는 작은 컵과 같습니다.

- 트랜지스터 (Transistor): 스위치 역할을 합니다. 커패시터에 데이터를 쓰거나 읽을 때 전하의 흐름을 제어합니다. 필요할 때만 데이터 흐름을 열거나 닫는 역할을 합니다.

커패시터에 저장된 전하는 시간이 지남에 따라 자연스럽게 누설되어 사라집니다. 마치 뚜껑이 없는 컵에 담긴 물이 서서히 증발하는 것과 같습니다. 따라서 데이터 손실을 막기 위해 DRAM 컨트롤러는 주기적으로 모든 메모리 셀의 전하 상태를 확인하고, 부족한 전하를 다시 채워 넣는 리프레시(Refresh) 작업을 수행해야 합니다. 이 리프레시 주기는 보통 수십 밀리초(ms) 단위로 매우 짧게 이루어지며, 이 과정에서 메모리에 대한 접근이 잠시 중단됩니다.

DRAM 모듈은 일반적으로 PCB(Printed Circuit Board) 위에 여러 개의 DRAM 칩을 배열한 형태로 구성됩니다. 이러한 모듈은 CPU와 메모리 컨트롤러를 통해 연결되며, 특정 주소에 해당하는 데이터를 읽거나 쓸 수 있도록 주소 버스(Address Bus)와 데이터 버스(Data Bus)를 통해 통신합니다. 전통적인 DRAM은 데이터 버스의 폭이 좁은 편이며, 클록(Clock) 주파수를 높여 대역폭을 확보하는 방식으로 발전해왔습니다.

DRAM의 광범위한 사용처와 주요 한계

DRAM은 저렴한 생산 비용, 상대적으로 높은 집적도, 그리고 CPU가 직접 접근할 수 있는 빠른 속도 덕분에 수십 년간 컴퓨팅 시스템의 주력 메모리로 자리매김했습니다. 개인용 컴퓨터(PC)의 주 메모리(RAM), 서버의 워크로드 처리, 스마트폰 및 태블릿과 같은 모바일 기기, 심지어 게임 콘솔에 이르기까지 광범위하게 사용됩니다. 전통적인 DRAM은 여전히 전 세계 대부분의 컴퓨팅 시스템에서 광범위하게 사용되며, 그 중요성을 이어가고 있습니다.

그러나 급변하는 AI와 고성능 컴퓨팅 메모리 환경은 DRAM의 한계를 명확히 드러내고 있습니다. 주요 한계점은 다음과 같습니다.

- 대역폭 한계: DRAM은 칩과 컨트롤러 간의 연결(버스)이 물리적으로 떨어져 있고 그 폭(Bus Width)이 제한적입니다. 이는 데이터를 한 번에 전송할 수 있는 양을 제한하여, 프로세서가 처리할 수 있는 데이터 양에 비해 메모리가 데이터를 공급하는 속도가 느려지는

메모리 병목 현상(Memory Bottleneck)을 초래합니다.메모리 대역폭 차이는 여기서 시작됩니다. - 전력 효율성 문제: 데이터 전송 거리가 멀고 많은 I/O(Input/Output) 핀을 사용해야 하므로, 데이터 전송 과정에서 상당한 전력이 소모됩니다. 특히 대규모 데이터 처리가 필요한 AI 시대에는 이러한 전력 소비가 발열 문제와 운영 비용 상승으로 이어집니다.

- 지연 시간 (Latency): CPU가 DRAM에 데이터 요청을 보낸 후 데이터를 실제로 받는 데까지 걸리는 시간이 상대적으로 깁니다. 이는 고속 연산이 중요한 AI/HPC 애플리케이션에서 성능 저하의 원인이 됩니다.

- 폼팩터 (Form Factor): 2D 평면 위에 칩을 배열하는 방식은 물리적 공간을 많이 차지하며, 시스템 전체의 소형화 및 고집적화에 제약을 줍니다.

이러한 DRAM의 한계는 AI 반도체 메모리의 새로운 요구사항과 맞물려 HBM이란 기술의 등장을 필연적으로 만들었습니다. 다음 섹션에서는 이러한 문제들을 HBM이 어떻게 혁신적으로 해결했는지 자세히 살펴보겠습니다.

고성능 컴퓨팅의 핵심, HBM의 등장 배경과 혁신 원리

앞서 살펴보았듯이, 전통적인 DRAM은 지난 수십 년간 컴퓨팅의 중추적인 역할을 해왔지만, AI 반도체 메모리와 고성능 컴퓨팅 메모리의 시대가 요구하는 초고속, 초고용량 데이터 처리에는 명확한 한계를 보였습니다. 프로세서의 연산 능력은 기하급수적으로 발전하는데 비해, 메모리가 데이터를 공급하는 속도가 이를 따라가지 못하는 메모리 병목 현상이 심화된 것입니다. 이러한 문제를 해결하고, 차세대 컴퓨팅 환경에 필요한 메모리 솔루션을 제공하기 위해 탄생한 것이 바로 HBM (High Bandwidth Memory)입니다. 과연 HBM이란 무엇이며, 어떤 혁신적인 원리로 이러한 문제들을 해결했을까요?

HBM 개발의 배경: DRAM의 한계를 극복하다

AI 모델의 복잡성은 상상을 초월합니다. 수십억 개에서 수천억 개의 파라미터를 가진 모델을 학습시키고 추론하기 위해서는 한 번에 엄청난 양의 데이터를 GPU와 같은 가속기에 공급해야 합니다. 예를 들어, 그래픽 처리 작업이나 AI 딥러닝 연산은 수많은 데이터를 병렬로 처리해야 하므로, 메모리와 프로세서 간의 메모리 대역폭 차이를 최소화하는 것이 절대적으로 중요합니다.

기존 DRAM은 좁은 버스(Bus)를 통해 데이터를 전송하며, 대역폭을 늘리기 위해 클록 주파수를 높이는 방식에 의존해왔습니다. 하지만 클록 주파수를 무한정 높이는 데는 물리적인 한계가 있으며, 높은 주파수는 더 많은 전력 소비와 발열로 이어져 전력 효율성 문제를 야기합니다. 또한, DRAM 칩이 프로세서와 멀리 떨어져 있으면 데이터가 오가는 물리적 거리가 길어져 지연 시간(Latency)이 증가하고 신호 무결성 유지도 어려워집니다.

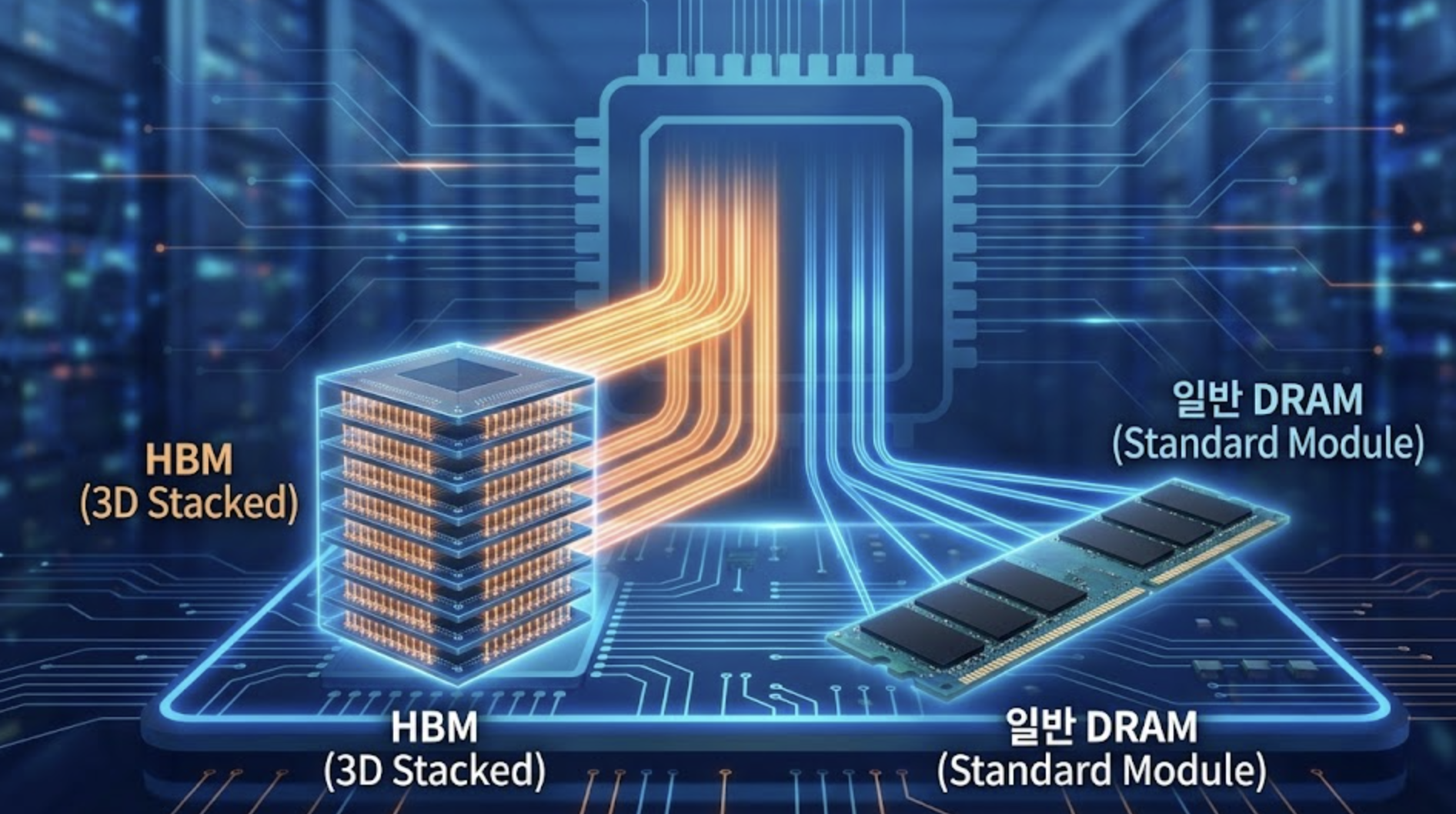

이러한 문제들을 근본적으로 해결하기 위해 개발된 HBM은 데이터를 더 빠르게, 더 많이, 더 효율적으로 전송하는 데 초점을 맞추었습니다. 그 핵심에는 3D 스태킹 기술과 넓은 인터페이스, 그리고 CoWoS 패키징이 있습니다.

HBM의 혁신적인 기술 원리 3가지

- 3D 스태킹 기술 (3D Stacking Technology):

HBM 3D 스태킹은 HBM의 가장 핵심적인 특징입니다. 기존 DRAM 칩은 2D 평면 위에 나란히 배열되었지만, HBM은 여러 개의 DRAM 칩을 수직으로 쌓아 올린 다음, 이들을TSV (Through-Silicon Via)라는 미세한 구멍을 통해 전기적으로 연결합니다. TSV는 실리콘 웨이퍼를 수직으로 관통하는 미세한 구리 기둥으로, 각 층의 칩들을 마치 고층 건물의 엘리베이터처럼 연결해줍니다.- 장점:

- 높은 집적도: 같은 면적에 더 많은 메모리 용량을 구현할 수 있습니다.

- 데이터 전송 거리 단축: 칩 간의 거리가 매우 짧아져 데이터 전송 시 발생할 수 있는 신호 손실과 지연 시간을 크게 줄일 수 있습니다.

- 장점:

- 넓은 인터페이스 (Wide Interface / High Bus Width):

기존 DRAM은 일반적으로 32비트나 64비트의 데이터 버스 폭을 가집니다. 반면 HBM은 하나의 DRAM 칩 스택(Stack)당 1024비트라는 훨씬 넓은 데이터 버스 폭을 제공합니다. 이는 한 번에 전송할 수 있는 데이터의 양이 압도적으로 많다는 것을 의미합니다.- 비유: 기존 DRAM이 좁은 1차선 도로라면, HBM은 16차선 고속도로와 같아서 훨씬 많은 차량(데이터)을 동시에 운반할 수 있습니다.

- 극대화된 대역폭: 넓은 버스 폭 덕분에 클록 주파수를 극단적으로 높이지 않아도 압도적인

메모리 대역폭을 달성할 수 있습니다. 예를 들어, 최신 HBM은 단일 스택에서 초당 수백 GB에서 1TB 이상의 데이터 전송 속도를 제공하며, 여러 스택이 결합된 시스템에서는 초당 수 테라바이트에 달하는 총 대역폭을 달성합니다.

- CoWoS 패키징 (Chip-on-Wafer-on-Substrate):

HBM은 일반적으로 GPU와 같은 호스트 프로세서 바로 옆에인터포저(Interposer)라는 특수 기판 위에 함께 패키징됩니다. 이 패키징 기술을 대표하는 것이 TSMC의 CoWoS(Chip-on-Wafer-on-Substrate)와 같은 기술입니다. 인터포저는 실리콘 기반으로 만들어져 미세한 배선을 포함하며, HBM 스택과 프로세서를 매우 짧은 거리에서 고밀도로 연결하는 역할을 합니다.- 장점:

- 초단거리 연결: 프로세서와 HBM 간의 데이터 전송 거리를 극도로 짧게 만들어 신호 지연을 최소화하고 전력 효율성을 극대화합니다.

- 시스템 통합: 메모리와 프로세서가 물리적으로 매우 가깝게 통합되어 하나의 강력한

AI 반도체 메모리솔루션을 형성합니다.

- 장점:

이러한 혁신적인 기술적 원리들이 결합되어 HBM은 기존 DRAM이 제공할 수 없었던 압도적인 성능과 효율성을 제공하며, 고성능 컴퓨팅 시대의 핵심 메모리 솔루션으로 자리 잡았습니다. 다음 섹션에서는 HBM DRAM 차이를 더욱 상세하게 비교 분석하여 각각의 장단점을 명확히 파악해보고자 합니다.

HBM과 DRAM의 핵심 차이점: 성능, 전력, 구조, 비용 비교

HBM과 DRAM은 현대 컴퓨팅 시스템에서 데이터를 저장하고 처리하는 두 가지 주요 메모리 기술이지만, 그 설계 철학과 작동 방식, 그리고 적용 분야에서 HBM DRAM 차이는 매우 큽니다. 이 섹션에서는 두 기술 간의 가장 중요한 HBM DRAM 비교 지점들을 심층적으로 분석하여 각각의 장단점을 명확히 제시하겠습니다. 특히 메모리 대역폭 차이, 전력 소비, 물리적 구조에 초점을 맞춥니다.

1. 대역폭 (Bandwidth): 데이터 처리 속도의 결정적 차이

대역폭은 메모리가 초당 처리할 수 있는 데이터의 양을 의미하며, 메모리 대역폭 차이는 HBM DRAM 차이를 설명하는 가장 중요한 지표 중 하나입니다.

- DRAM: 전통적인 DRAM(예: DDR5)은 일반적으로 64비트 폭의 데이터 버스를 사용합니다. 대역폭을 높이기 위해 주로 클록 주파수(Clock Frequency)를 높이는 전략을 취합니다. 예를 들어, DDR5-4800 DRAM은 초당 약 38.4GB의 대역폭을 제공합니다. 이는 일반적인 PC나 서버의 워크로드에는 충분하지만,

AI 반도체 메모리나고성능 컴퓨팅 메모리에서 요구하는 수 TB/s급의 대역폭에는 턱없이 부족합니다. - HBM:

HBM이란기술은 넓은 인터페이스(Wide Interface)에 중점을 둡니다. HBM 스택 하나는 1024비트의 데이터 버스 폭을 가지며, 이는 DRAM보다 16배 이상 넓은 폭입니다. 여기에3D 스태킹기술과 인터포저를 통한 초단거리 연결이 더해져 압도적인 대역폭을 실현합니다. 예를 들어, HBM3E는 단일 스택에서 초당 1.28TB 이상의 대역폭을 제공하며, 하나의 GPU에 여러 스택이 결합되면 수 TB/s에 달하는 총 대역폭을 달성할 수 있습니다. 이는 AI 가속기나 슈퍼컴퓨터와 같이 방대한 데이터셋을 병렬로 처리해야 하는 환경에서메모리 병목 현상을 해소하는 결정적인 역할을 합니다.

2. 전력 소비 (Power Consumption): 효율성의 재정의

전력 효율성은 특히 데이터 센터 운영 비용 및 발열 관점에서 매우 중요합니다.

- DRAM: DRAM은 프로세서와 물리적으로 거리가 멀리 떨어져 있어, 데이터 신호가 긴 거리를 이동해야 합니다. 이 과정에서 발생하는 저항과 용량성 부하 때문에 데이터 전송에 상대적으로 많은 전력이 소모됩니다. 또한, 높은 클록 주파수를 유지하는 것 자체가 전력 소비를 증가시키는 요인입니다. 이로 인해 대규모 DRAM 모듈을 사용하는 서버는 상당한 전력을 소비하고, 이에 따른 발열 문제도 커집니다.

- HBM:

HBM 3D 스태킹과 CoWoS 패키징은 전력 효율성 측면에서 큰 이점을 제공합니다. 칩 스택 내에서의 데이터 전송은 매우 짧은 TSV를 통해 이루어지며, 프로세서와의 연결도 인터포저를 통해 초단거리에서 이루어집니다. 데이터 전송 거리가 짧아지면 필요한 전압이 낮아지고, 이는 전력 소비를 현저히 줄이는 결과를 낳습니다. HBM은 낮은 클록 주파수에서도 넓은 대역폭을 확보할 수 있어, 동일한 대역폭을 제공하는 DRAM 대비 훨씬 적은 전력을 소모합니다. 이는AI 반도체 메모리와 같은 고성능 시스템에서 발열을 줄이고 운영 비용을 절감하는 데 핵심적인 역할을 합니다.

3. 물리적 구조 및 집적도 (Physical Structure & Density): 공간 활용의 혁신

두 메모리 기술은 물리적 구조와 집적도에서도 극명한 HBM DRAM 차이를 보입니다.

- DRAM: 전통적인 DRAM 칩은 2D 평면 위에 배열되며, 일반적으로 DIMM(Dual In-line Memory Module)이라는 형태로 PCB(Printed Circuit Board)에 장착됩니다. 이는 물리적 공간을 많이 차지하며, 칩과 칩, 그리고 칩과 프로세서 간의 거리가 상대적으로 멉니다. 집적도를 높이는 데 한계가 있으며, 대용량 메모리 시스템을 구성하려면 많은 수의 DIMM 슬롯이 필요합니다.

- HBM:

HBM이란이름이 말해주듯, HBM은 여러 개의 DRAM 다이(Die)를 수직으로3D 스태킹하여 하나의 패키지로 만듭니다. 이 스택은 GPU와 같은 프로세서 바로 옆, 동일한 인터포저 위에 실장됩니다. 이러한 구조는 매우 높은 메모리 집적도를 가능하게 하며, 시스템 전체의 공간 효율성을 극대화합니다. 더 적은 면적에 더 많은 용량의 메모리를 구현할 수 있으므로, 고성능 프로세서와 메모리를 긴밀하게 통합하는 데 매우 유리합니다.

4. 지연 시간 (Latency): 접근 속도의 미묘한 차이

지연 시간은 메모리에 데이터를 요청한 후 응답을 받는 데 걸리는 시간입니다.

- DRAM: DRAM은 프로세서에서 멀리 떨어져 있고, 복잡한 메모리 컨트롤러를 통해 접근하기 때문에 상대적으로 높은 지연 시간을 가집니다. 특히 캐시 미스(Cache Miss)가 발생하여 메인 메모리에 접근해야 할 때 이 지연 시간은 시스템 성능에 영향을 미칩니다.

- HBM: HBM은 프로세서와 물리적으로 매우 가깝고, 넓은 데이터 버스를 통해 효율적으로 데이터를 전송할 수 있어 이론적으로는 지연 시간이 짧을 것이라고 생각할 수 있습니다. 그러나 HBM은 높은 대역폭에 초점을 맞춘 설계이며, 실제 절대적인 지연 시간 자체는 특정 DRAM 구성에 따라 드라마틱하게 짧아지지는 않을 수 있습니다. 중요한 것은 높은 대역폭으로 인해 대량의 데이터를 빠르게 전송할 수 있어, 실질적인

유효 지연 시간(Effective Latency)이 개선된다는 점입니다. 즉, 필요한 데이터를 더 빨리 모두 가져올 수 있으므로 전체적인 작업 완료 시간이 단축됩니다.

5. 비용 및 복잡성 (Cost & Complexity): 현실적인 고려사항

HBM DRAM 비교에서 중요한 현실적인 측면은 바로 비용입니다.

- DRAM: 표준화된 제조 공정과 대량 생산 시스템 덕분에 단위 용량당 비용이 매우 저렴합니다. 이는 일반 소비자 시장과 범용 서버 시장에서 DRAM이 여전히 압도적인 주류로 남아있는 이유입니다.

- HBM:

HBM 3D 스태킹과 CoWoS 패키징 기술은 매우 복잡하고 정교한 공정을 요구합니다. TSV 형성, 마이크로 범프(Micro Bump)를 이용한 접합, 인터포저 제작 등 첨단 기술이 필요하므로, 단위 용량당 제조 비용이 DRAM보다 훨씬 높습니다. 이로 인해 HBM은 주로 고가의AI 반도체 메모리및 HPC 시스템에 제한적으로 사용됩니다.

이처럼 HBM DRAM 차이는 단순히 성능 수치 이상의 복합적인 기술적, 경제적 고려사항을 포함합니다. 다음 섹션에서는 이러한 차이점들이 실제 산업에서 어떻게 적용되는지 구체적인 사용 사례를 통해 살펴보겠습니다.

각 메모리의 주요 사용처와 적용 분야: AI 가속기부터 일반 PC까지

HBM과 DRAM은 각각 고유한 기술적 특성과 비용 효율성을 가지고 있기 때문에, 적용되는 컴퓨팅 환경과 목적이 명확하게 구분됩니다. HBM DRAM 차이를 이해하는 것은 어떤 메모리 솔루션이 특정 애플리케이션에 가장 적합한지 판단하는 데 필수적입니다. 이 섹션에서는 각 메모리 기술의 대표적인 사용처와 그 배경을 설명합니다.

HBM의 주요 사용처: 고성능 연산의 심장

HBM이란 기술은 주로 압도적인 메모리 대역폭이 필요한 최첨단 고성능 컴퓨팅 메모리 시스템에 사용됩니다. 이들은 AI 반도체 메모리의 핵심 구성 요소로 자리 잡았습니다.

- AI 가속기 (AI Accelerators) 및 GPU:

- 사용처: NVIDIA의 A100, H100 GPU, AMD의 Instinct MI 시리즈, 그리고 Google의 TPU(Tensor Processing Unit)와 같은 AI 학습 및 추론용 가속기에 HBM이 광범위하게 사용됩니다.

- 핵심 이유: 딥러닝 모델은 수십억, 수천억 개의 파라미터를 가지며, 학습 과정에서 이 파라미터들과 대규모 데이터셋을 엄청난 속도로 행렬 연산을 수행해야 합니다. GPU의 병렬 처리 능력이 아무리 뛰어나도, 메모리가 필요한 데이터를 제때 공급하지 못하면 GPU는 유휴 상태가 됩니다. HBM의 초고대역폭은 GPU가 방대한 데이터를 지연 없이 처리할 수 있도록 하여, 학습 시간을 단축하고 모델의 성능을 극대화합니다.

HBM DRAM 비교에서 HBM이 AI 가속기 시장의 표준이 된 것은 바로 이 때문입니다.

- 고성능 컴퓨팅 (HPC) 시스템 및 슈퍼컴퓨터:

- 사용처: 기후 모델링, 핵융합 시뮬레이션, 신약 개발, 유체 역학 분석 등 복잡하고 대규모 연산을 수행하는 슈퍼컴퓨터 및 HPC 시스템에 HBM이 필수적으로 적용됩니다.

- 핵심 이유: 이러한 과학 및 공학 시뮬레이션은 테라바이트급 데이터를 실시간으로 처리하며, 이들 데이터 간의 복잡한 상호작용을 계산해야 합니다. HBM은 병렬 처리되는 연산 코어에 안정적이고 빠른 데이터 스트림을 제공하여, 시뮬레이션의 정확도와 속도를 향상시킵니다.

고성능 컴퓨팅 메모리의 진정한 잠재력을 발휘하기 위해서는 HBM과 같은 고대역폭 솔루션이 필수적입니다.

- 네트워크 장비 (Network Equipment) 및 고성능 라우터:

- 사용처: 초고속 데이터 전송이 필요한 통신망 코어 라우터, 스위치, 방화벽 등 첨단 네트워크 장비에도 HBM이 도입되고 있습니다.

- 핵심 이유: 대규모 네트워크 트래픽을 처리하고 패킷을 고속으로 분류, 전달하는 과정에서도 엄청난 양의 데이터가 메모리에 빠르게 접근되어야 합니다. HBM은 이러한 네트워크 장비의 처리량을 극대화하고 지연 시간을 최소화하여, 원활하고 안정적인 통신 서비스를 제공하는 데 기여합니다.

DRAM의 주요 사용처: 범용 컴퓨팅의 근간

DRAM의 낮은 단위 비용과 범용성은 여전히 매력적인 요소입니다. 전통적인 DRAM은 여전히 전 세계 대부분의 컴퓨팅 시스템에서 광범위하게 사용되며, 그 중요성을 이어가고 있습니다.

- 일반 소비자 PC (Personal Computers):

- 사용처: 데스크톱, 노트북, 워크스테이션 등 일반 소비자가 사용하는 모든 PC의 메인 메모리(RAM)로 사용됩니다.

- 핵심 이유: 웹 브라우징, 문서 작업, 비디오 편집, 일반적인 게임 플레이 등 대부분의 일상적인 컴퓨팅 작업은

HBM이 제공하는 극단적인 대역폭까지 필요로 하지 않습니다. DDR4, DDR5와 같은 표준 DRAM은 충분한 성능을 합리적인 가격에 제공하며, 시스템의 전반적인 반응 속도와 멀티태스킹 능력을 담당합니다.

- 일반 서버 (General Purpose Servers) 및 클라우드 데이터 센터:

- 사용처: 웹 서버, 데이터베이스 서버, 가상화 서버 등 일반적인 클라우드 서비스와 기업 데이터 센터의 대부분의 서버에서 DRAM이 사용됩니다.

- 핵심 이유: 이들 서버는 다양한 워크로드를 처리하며, 특정 애플리케이션이 HBM과 같은 극단적인 대역폭을 요구하기보다는 대용량 메모리와 안정적인 성능, 그리고 무엇보다

비용 효율성이 중요합니다. DRAM은 기가바이트(GB)당 가격이 저렴하여 대규모 서버 팜을 구축하는 데 경제적인 선택지입니다. 물론, AI/HPC 워크로드를 위한 특수 서버에는 HBM이 탑재됩니다.

- 모바일 기기 (Mobile Devices) 및 임베디드 시스템:

- 사용처: 스마트폰, 태블릿, 웨어러블 기기, 그리고 자동차의 인포테인먼트 시스템과 같은 임베디드 장치에 LPDDR(Low Power Double Data Rate) DRAM이 사용됩니다.

- 핵심 이유: 모바일 및 임베디드 환경에서는

전력 효율성과소형화가 가장 중요한 요소입니다. LPDDR은 일반 DRAM 대비 낮은 전압에서 작동하여 배터리 수명을 연장하고, 칩 패키징도 소형화에 유리하게 설계됩니다. 이들 장치는 HBM이 제공하는 엄청난 대역폭보다는 적절한 성능과 긴 배터리 수명을 우선시합니다.

이처럼 HBM과 DRAM은 각자의 장점을 바탕으로 특정 시장에서 최적의 솔루션을 제공하며 공존하고 있습니다. HBM DRAM 비교를 통해 알 수 있듯이, 기술 선택은 항상 요구되는 성능, 전력 효율성, 그리고 비용이라는 삼박자를 고려하여 이루어져야 합니다. 다음 섹션에서는 이 두 메모리 기술이 앞으로 어떻게 발전하고 새로운 형태로 진화할지 미래 기술 동향을 예측해 봅니다.

미래를 위한 메모리: HBM의 발전과 DRAM의 지속적인 역할

메모리 기술은 항상 컴퓨팅 시스템의 발전에 발맞춰 진화해왔습니다. AI 반도체 메모리 시대를 맞아 HBM이 새로운 패러다임을 제시했지만, 그렇다고 해서 전통적인 DRAM의 역할이 축소되거나 사라지는 것은 아닙니다. 오히려 두 기술은 각자의 영역에서 지속적으로 발전하며, 때로는 서로 보완하는 형태로 미래 컴퓨팅 환경을 만들어갈 것입니다. HBM이란 기술이 어떻게 진화해왔는지, 그리고 DRAM은 어떻게 그 역할을 유지하고 발전하는지 살펴보겠습니다.

HBM 기술의 진화 로드맵: 끝없는 성능 향상

HBM 3D 스태킹 기술은 2013년 처음 등장한 이래로 놀라운 속도로 발전해왔습니다. 각 세대별로 대역폭, 용량, 전력 효율성 측면에서 괄목할 만한 개선을 이루어냈습니다.

- HBM (1세대): 2013년 첫 선을 보인 HBM은 1024비트의 넓은 인터페이스와 TSV 기술을 도입하며 기존 DRAM의 한계를 돌파했습니다.

- HBM2: 2016년 발표된 HBM2는 대역폭을 더욱 향상시키고, 스택당 용량도 8GB까지 늘리며 AI 가속기 및 HPC 시장에서 본격적인 채택이 이루어졌습니다.

- HBM2E: HBM2의 확장 버전으로, 대역폭과 용량을 더욱 끌어올렸습니다. 스택당 최대 16GB의 용량과 초당 400GB 이상의 대역폭을 제공하며, 현재도 많은 AI 칩에 사용됩니다.

- HBM3: 2022년부터 상용화된 HBM3는 대역폭과 용량을 한 단계 더 도약시켰습니다. 스택당 최대 24GB의 용량과 초당 819GB 이상의 대역폭을 제공하며, 특히

AI 반도체 메모리분야의 선두 주자들이 채택하고 있습니다. HBM3는 더 낮은 전압에서 작동하여 전력 효율성도 크게 개선했습니다. - HBM3E (Extended): HBM3의 성능을 극한으로 끌어올린 확장 버전입니다. 초당 1.2TB를 넘어서는 압도적인 대역폭을 목표로 하며, 2024년부터 차세대 AI 칩에 탑재될 예정입니다. 이는 HBM3 대비 약 50% 향상된 대역폭을 제공합니다.

- HBM4 및 그 이후: 이미 다음 세대인 HBM4에 대한 연구 개발이 활발히 진행 중입니다. HBM4는 스택당 용량을 36GB 이상으로 늘리고, 대역폭 또한 2TB/s를 목표로 하고 있습니다. 미래에는 HBM 스택 자체에 프로세싱 유닛을 통합하여 데이터 이동을 최소화하는

PIM (Processing-in-Memory)기술과의 결합도 예상됩니다.

이처럼 HBM이란 기술은 매년 혁신을 거듭하며 고성능 컴퓨팅 메모리의 한계를 꾸준히 넓혀가고 있습니다.

고성능 DRAM의 발전: GDDR6X 등의 역할

HBM DRAM 비교에서 HBM이 AI/HPC의 최전선을 담당한다면, DRAM은 범용성과 비용 효율성을 바탕으로 다른 고성능 영역에서도 발전을 멈추지 않고 있습니다. 특히 GDDR(Graphics Double Data Rate) 계열의 DRAM은 고성능 그래픽 카드와 일부 AI 추론용 칩에서 중요한 역할을 합니다.

- GDDR6X: NVIDIA와 마이크론이 공동 개발한 GDDR6X는 독자적인 PAM4(Pulse Amplitude Modulation 4-level) 신호 변조 기술을 사용하여 클록 사이클당 더 많은 데이터를 전송합니다. 이를 통해 GDDR6 대비 약 2배 빠른 속도를 구현하며, HBM만큼은 아니지만 상당한 수준의 대역폭을 제공합니다. GDDR6X는 주로 고성능 게이밍 GPU, 일부 워크스테이션용 GPU, 그리고 AI 추론 가속기 등

AI 반도체 메모리중에서도 비용과 대역폭의 균형을 맞춘 솔루션으로 활용됩니다. HBM보다 저렴하면서도 높은 대역폭을 제공하여, 특정 애플리케이션에서HBM DRAM 차이를 메우는 중간 다리 역할을 합니다.

HBM과 DRAM의 공존과 미래 기술 동향

미래에도 HBM과 DRAM은 각자의 강점을 바탕으로 공존할 것입니다.

- 전문화된 역할: HBM은 계속해서 AI 학습, 대규모 시뮬레이션, 데이터 센터의 최상위 계층 등 극강의 대역폭과 전력 효율성이 필요한 애플리케이션에 집중될 것입니다. 반면, DRAM은 일반 PC, 스마트폰, 범용 서버, 그리고 비용에 민감한 IoT(사물 인터넷) 기기 등 대다수의 컴퓨팅 환경에서 효율적인 주력 메모리로 그 위치를 공고히 할 것입니다.

- 하이브리드 시스템: 일부 시스템에서는 HBM과 DRAM이 함께 사용되는 하이브리드 메모리 아키텍처가 등장하거나 이미 연구되고 있습니다. 예를 들어, HBM은 가장 중요한 데이터를 위한 초고속 캐시처럼 작동하고, DRAM은 더 큰 용량의 메인 메모리 역할을 하는 방식입니다.

- 새로운 인터페이스 기술의 등장: CXL(Compute Express Link)과 같은 새로운 인터페이스 기술은 메모리 계층 구조를 더욱 유연하게 만들고 있습니다. CXL은 CPU, GPU, 가속기 등이 공유 메모리 풀에 접근할 수 있도록 하여, HBM과 DRAM을 더욱 효율적으로 활용하고 메모리 용량과 대역폭을 확장하는 새로운 길을 열고 있습니다.

- PIM(Processing-in-Memory)의 발전: 메모리 칩 내부에 연산 기능을 통합하여 데이터 이동을 최소화하고 에너지 소비를 줄이는 PIM 기술은 HBM과 결합될 때 엄청난 시너지를 낼 수 있습니다. 이는 특히 AI/ML 연산에서 병목 현상을 해결하는 혁신적인 접근법으로 주목받고 있습니다.

결론적으로, HBM이란 기술은 AI 반도체 메모리의 새로운 시대를 열었지만, DRAM 원리를 바탕으로 하는 전통 DRAM 또한 끊임없이 발전하며 다양한 컴퓨팅 요구사항을 충족시키고 있습니다. 이 두 가지 메모리 기술은 경쟁을 넘어 상호 보완적인 관계로 발전하며, 미래 컴퓨팅의 지평을 더욱 넓혀갈 것입니다.

결론: HBM과 DRAM, 올바른 이해를 통한 최적의 기술 활용 가이드

지금까지 우리는 HBM과 DRAM이라는 현대 컴퓨팅의 두 가지 핵심 메모리 기술을 심도 있게 탐구했습니다. HBM DRAM 차이의 근간을 이루는 DRAM 원리와 HBM이란 기술의 혁신적인 HBM 3D 스태킹 원리부터 시작하여, 메모리 대역폭 차이, 전력 소비, 물리적 구조, 그리고 주요 사용처까지 상세하게 HBM DRAM 비교 분석했습니다. AI 반도체 메모리와 고성능 컴퓨팅 메모리 시장에서 HBM이 왜 필수적인지, 그리고 DRAM이 여전히 광범위하게 사용되는 이유와 미래 발전 방향까지 다루면서, 두 기술이 각자의 영역에서 얼마나 중요한 역할을 하는지 확인했습니다.

핵심 요약: HBM과 DRAM의 명확한 구분

두 메모리 기술의 주요 차이점을 다시 한번 요약하자면 다음과 같습니다.

- HBM (고대역폭 메모리):

- 강점: 압도적인

메모리 대역폭(수백 GB/s ~ 수 TB/s), 뛰어난 전력 효율성, 높은 공간 효율성 (3D 스태킹), 프로세서와의 초단거리 연결. - 단점: 높은 제조 비용, 복잡한 패키징 기술, 상대적으로 낮은 최대 용량(개별 스택 기준).

- 주요 사용처: AI 가속기 (GPU), HPC 시스템, 슈퍼컴퓨터 등 극강의 대역폭과 전력 효율성이 필수적인 분야.

- 강점: 압도적인

- DRAM (다이내믹 램):

- 강점: 저렴한 단위 용량당 비용, 높은 최대 용량 (DIMM 모듈 기준), 범용성, 광범위한 호환성.

- 단점: 상대적으로 낮은 대역폭 (수십 GB/s), 높은 전력 소비 (데이터 전송 거리),

메모리 병목 현상발생 가능성. - 주요 사용처: 일반 소비자 PC, 범용 서버 및 클라우드 데이터 센터, 모바일 기기 등 비용 효율성과 대용량이 중요한 분야.

실무자를 위한 기술 활용 가이드

HBM DRAM 차이에 대한 명확한 인지는 단순히 기술적 호기심을 넘어, 특정 컴퓨팅 환경에서 최적의 메모리 솔루션을 선택하고 시스템을 설계하는 데 필수적인 인사이트를 제공합니다. 시스템 아키텍트, 개발자, IT 관리자라면 다음 사항을 고려하여 메모리 전략을 수립해야 합니다.

- 워크로드 특성 분석:

- 대역폭 집중 워크로드: AI 딥러닝 학습/추론, 대규모 행렬 연산, 과학 시뮬레이션 등

메모리 대역폭이 성능의 병목이 되는 작업에는 HBM이 탑재된 시스템을 우선 고려해야 합니다. - 용량/비용 집중 워크로드: 웹 서버, 데이터베이스, 일반 애플리케이션 서버 등 대용량 메모리가 필요하고 GB당 비용 효율성이 중요한 작업에는 표준 DRAM이 최적의 선택입니다.

- 대역폭 집중 워크로드: AI 딥러닝 학습/추론, 대규모 행렬 연산, 과학 시뮬레이션 등

- 비용-성능 균형 고려:

HBM은 압도적인 성능을 제공하지만, 높은 초기 투자 비용이 수반됩니다.HBM DRAM 비교시 총 소유 비용(TCO)을 반드시 고려해야 합니다. 필요한 성능 수준을 초과하는 과도한 HBM 투자는 비효율적일 수 있습니다. - 전력 효율성 및 냉각 솔루션:

고성능 컴퓨팅 메모리시스템에서 HBM은 단위 대역폭당 효율이 높지만, 시스템 전체의 발열량은 여전히 상당합니다. 따라서 HBM 시스템에서는 고급 냉각 솔루션에 대한 고려가 필수적입니다. - 미래 확장성 및 기술 로드맵:

새로운 HBM 세대(HBM4 등)와 DRAM 표준(DDR6)이 지속적으로 개발되고 있습니다. 시스템 설계 시 현재 워크로드뿐만 아니라 향후 기술 로드맵을 고려하여 유연한 아키텍처를 계획하는 것이 중요합니다. CXL과 같은 새로운 인터페이스 기술의 등장은 메모리 자원의 활용 방식에 혁신을 가져올 것입니다.

결론적으로, HBM과 DRAM은 서로 다른 목적과 강점을 가진 AI 반도체 메모리 기술이며, 둘 중 어느 하나가 절대적으로 우수하다고 단정할 수 없습니다. 중요한 것은 각 기술의 특성을 정확히 이해하고, 특정 애플리케이션의 요구사항과 예산 제약을 고려하여 가장 합리적이고 효율적인 메모리 솔루션을 선택하는 지혜입니다. 이 글이 HBM과 DRAM에 대한 여러분의 이해를 돕고, AI 시대 고성능 메모리 활용 전략 수립에 실질적인 가이드라인을 제공했기를 바랍니다. 급변하는 기술의 흐름 속에서 올바른 지식은 항상 최적의 선택으로 이어질 것입니다.

'DEV' 카테고리의 다른 글

| macOS Cron Job 마스터 가이드: 반복 작업 자동화부터 고급 설정까지 (0) | 2026.01.28 |

|---|---|

| SSD 핵심 기술 완전 정복: SLC, MLC, TLC, QLC 셀 타입 완벽 분석 및 구매 가이드 (0) | 2026.01.28 |

| AI 시대의 핵심 두뇌: CPU, GPU, NPU 전격 비교 (성능, 역할, 차이점 완벽 분석) (0) | 2026.01.28 |

| Amazon EC2 인스턴스 유형: 성능과 비용을 최적화하는 완벽 가이드 (0) | 2026.01.28 |

| 공진화 전략: 상생을 넘어 동반성장으로, 미래 비즈니스 성공을 위한 로드맵 (0) | 2026.01.28 |

- Total

- Today

- Yesterday

- 업무자동화

- 개발자가이드

- 데이터베이스

- 프롬프트엔지니어링

- Java

- LLM

- 자바개발

- 성능최적화

- AI

- 클린코드

- n8n

- 웹개발

- 생성형AI

- 인공지능

- restapi

- springai

- 프론트엔드개발

- 마이크로서비스

- 웹보안

- 개발생산성

- 백엔드개발

- 클라우드컴퓨팅

- 배민

- AI기술

- 개발가이드

- 미래ai

- AI반도체

- 로드밸런싱

- 개발자성장

- SEO최적화

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |